美国封锁没意义!揭秘华为384颗自研芯片方案 领先英伟达AMD一代

快科技5月17日消息,美国封杀华为芯片从某种程度来说,其实是对后者技术的认可,而他们确实也有硬实力做支撑。之前华为推出了AI算力集群解决方案CloudMatrix 384,虽然外行看起来没有什么厉害的,但国外投行直言,这领先于英伟达和AMD目前市场上的产品一代。

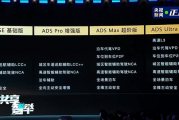

按照华为的说法,CloudMatrix 384基于384颗昇腾芯片构建,通过全互连拓扑架构实现芯片间高效协同,可提供高达300 PFLOPs的密集BF16算力,接近达到英伟达GB200 NVL72系统的两倍。

此外,CM384在内存容量和带宽方面同样占据优势,总内存容量超出英伟达方案3.6倍,内存带宽也达到2.1倍,为大规模AI训练和推理提供了更高效的硬件支持。

尽管单颗昇腾芯片性能约为英伟达Blackwell架构GPU的三分之一,但华为通过规模化系统设计,成功实现整体算力跃升,并在超大规模模型训练、实时推理等场景中展现更强竞争力。

在昨日的华为云AI峰会上,华为云副总裁黄瑾介绍了更多CloudMatrix 384超节点技术优势与细节,其指出随着大模型训练和推理对算力需求的爆炸式增长,传统计算架构已难以支撑AI技术的代际跃迁,超节点架构的诞生不仅是技术的突破,更是以工程化创新开辟AI产业的新路径。

当前,大模型训练经历了从早期小模型在单卡训练、小参数大模型在单机训练,到现在MoE、长序列、多模态大模型都在AI集群上训练的演进过程。

AI算力的瓶颈,从单卡算力的瓶颈到单机内总线带宽的瓶颈,再到现在集群间通信带宽的瓶颈,需求增长了1万倍。

然而过去的8年里,单卡硬件的算力增长了40倍,但是节点内的总线带宽只增长了9倍,跨节点的网络带宽只增长了4倍,这使得集群网络通信成为当前大模型训练和推理的最大挑战。

黄瑾表示,面对这些挑战,华为云推出了采用全对等互联架构的CloudMatrix 384超节点。这项技术创新跳出单点技术限制走向系统性、工程性的创新算力架构,直面通信效率瓶颈、内存墙制约、可靠性短板三大技术挑战。通过新型高速互联总线实现384张卡互联成为一个超级云服务器,最高提供300Pflops的算力规模,比业界同类产品领先67%。

目前,基于CloudMatrix的超节点集群已经在芜湖、贵安、内蒙规模上线,而华为云超节点创新系统架构的背后,是华为云坚持“昇腾云服务支持百模千态,盘古大模型重塑千行万业”的战略。

“一直以来华为云持续推动昇腾AI云服务全面升级,通过打磨昇腾云的训练、推理的性能、可靠性和性价比,为中国乃至全球客户提供好用、易用的AI算力云服务。现已全面适配了DeepSeek在内的160多个大模型,以云服务的方式,协助客户进行模型的开发,训练,托管和应用。”

美国封锁没意义!揭秘华为384颗自研芯片方案 领先英伟达AMD一代

【本文结束】出处:快科技

版权声明

本站所有文章来源于本站原创或网络,如有侵权请联系删除。文章观点并不代表本站观点,请网友自行判断,如涉及投资、理财请谨慎应对!

德阳吧

德阳吧

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。